前言

全局命令

在环境变量中增加如下命令,可以使用 bd 快速切换到 /data/tools/bigdata

1 | cd /etc/profile.d/ |

内容如下

1 | alias bd='cd /data/tools/bigdata' |

配置生效

1 | source /etc/profile |

Sqoop的安装

下载地址

http://archive.apache.org/dist/sqoop/1.4.7/

上传至虚拟机,并解压

1 | tar -zxvf sqoop-1.4.7.bin__hadoop-2.6.0.tar.gz -C /data/tools/bigdata |

环境变量

创建配置文件

1 | vi /etc/profile.d/sqoop.sh |

内容设置为

1 | # SQOOP |

配置生效

1 | source /etc/profile |

查看是否生效

1 | echo $SQOOP_HOME |

查看sqoop版本

1 | sqoop version |

帮助

1 | sqoop help |

连接MySQL

拷贝JDBC驱动

上传jdbc驱动到/opt/software目录中。

进入存放jdbc驱动的目录下,拷贝jdbc驱动到sqoop的lib目录下

1 | cp /root/mysql-connector-java-5.1.40.jar $SQOOP_HOME/lib/ |

测试Sqoop连接数据库

进入sqoop安装目录,执行

1 | sqoop list-databases --connect jdbc:mysql://master:3306/ --username root --password psvmc123 |

配置

Sqoop的配置文件与大多数大数据框架类似,在sqoop根目录下的conf目录中。

进入sqoop下面的conf

命令:

1 | cd $SQOOP_HOME/conf |

重命名配置文件sqoop-env-template.sh

1 | mv sqoop-env-template.sh sqoop-env.sh |

修改配置文件 sqoop-env.sh

命令:

1 | vi sqoop-env.sh |

修改一下内容:

1 | export HADOOP_COMMON_HOME=/data/tools/bigdata/hadoop-2.7.7 |

先不使用Zookeeper

hive数据导出到MySQL

hive中建表

准备数据,数据格式要和表结构相对应

1 | vi /root/student.txt |

在student.txt文件中加入以内容:

1 | 19308001,zhangsan,20,111111,222222 |

注:以什么为分隔符,就用什么符号,这里使用的是逗号为分隔符

启动Hive

1 | cd /data/tools/bigdata/apache-hive-2.3.9-bin |

查询表

1 | show tables; |

先在hive中创建表,数据类型和MySQL中的数据类型相对应

1 | create table student |

将txt文件数据导入到hive中

1 | load data local inpath '/root/student.txt' into table student; |

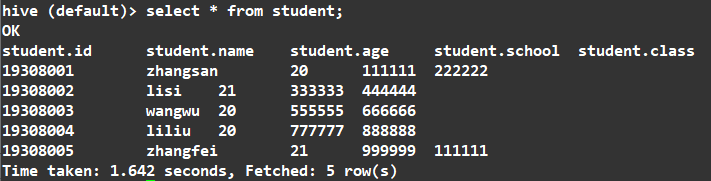

(4)查看表中数据

1 | select * from student; |

如图所示:

MySQL中建表

登录MySQL

1 | mysql -uroot -p |

创建一个数据库

1 | create database hive; |

使用hive数据库

1 | use hive; |

数据库中创建表

1 | create table student (id varchar(50),name varchar(50),age int,school varchar(50),class varchar(50)); |

添加一条数据

1 | insert into student values('19308009','wangmazi','22','666666','777777'); |

hive=>MySQL

运行

1 | sh $HADOOP_HOME/sbin/start-all.sh |

输入

1 | jps |

停止

1 | sh $HADOOP_HOME/sbin/stop-all.sh |

sqoop将hive中的数据传输到MySQL中

执行命令

1 | sqoop export --connect jdbc:mysql://master:3306/hive --username root --password psvmc123 --table student --num-mappers 1 --export-dir /user/hive/warehouse/student --input-fields-terminated-by ',' |

说明

| 项 | 说明 |

|---|---|

| master:3306/hive | hive是指MySQL中的数据库 |

| –export-dir /user/hive/warehouse/student | 导出数据的目录 |

| –input-fields-terminated-by ‘,’ | 导出数据时,使用什么分隔符分割字段 |

| –table student | 导出到 MySQL 的哪张表 |

hive创建的表在hdfs上面的位置为:/user/hive/warehouse/student

成功后进入MySQL数据库中查询数据

登录MySQL

1 | mysql -uroot -p |

使用hive数据库

1 | use hive; |

查看数据

1 | select * from student; |