前言

在测试模型的时候,按照模型的说明安装依赖,发现vLLM一直不成功。

原来是在Windows平台没有我所选版本的依赖。

注意

vLLM只能在英伟达的GPU上使用。

vLLM 官方 wheel 仅提供

cu118/cu121/cu124,无 Windows 原生支持Windows 可以通过WSL2 内安装vLLM。

uv文档

vLLM文档

驱动安装

Windows终端执行

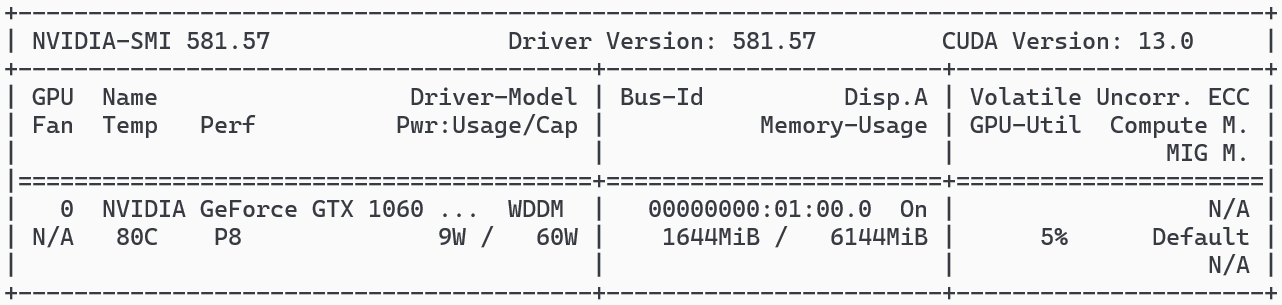

从NVIDIA官网下载对应显卡的Windows驱动,安装完成后通过nvidia-smi验证。

查看能安装的CUDA版本

1 | nvidia-smi |

注意:

nvidia-smi显示的是 驱动支持的最高 CUDA 运行时版本,不是你安装的 CUDA Toolkit 版本。

如果不显示则要先安装驱动

WSL2配置

通过PowerShell安装Linux子系统,推荐使用Ubuntu 22.04 LTS发行版。

1 | wsl --install |

我这里使用上面命令安装总是卡住不动,这里推荐在Microsoft Store 上下载

注意这里安装Ubuntu 22.04.5 LTS版本

安装后需在Windows设置中启用”虚拟机平台”和”WSL2”选项,并通过wsl --set-default-version 2确保默认使用WSL2。

1 | wsl --set-default-version 2 |

CUDA Toolkit安装

查看CUDA是否安装

1 | nvcc --version |

查看最高支持的CUDA版本

1 | nvidia-smi |

查看结果

注意:

nvidia-smi显示的是 驱动支持的最高 CUDA 运行时版本,不是你安装的 CUDA Toolkit 版本。我这里是

13.0,也就是说CUDA Toolkit下载13.0及以下的版本就行。

下载地址

CUDA Toolkit Archive | NVIDIA Developer

推荐版本 CUDA Toolkit 12.4

- 生态最成熟(PyTorch/TensorFlow/vLLM 都支持)

- Windows 安装包稳定

- NVIDIA 官方长期维护

在线安装

1 | wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.1-1_all.deb |

这里安装比较费时,请耐心等待。

配置环境变量

1 | echo 'export PATH=/usr/local/cuda-12.4/bin:$PATH' >> ~/.bashrc |

查看CUDA是否安装

1 | nvcc --version |

uv安装

详情参考

自动安装

1 | curl -LsSf https://astral.org.cn/uv/install.sh | sh |

手动安装

1 | # 下载 + 安装到 ~/.local/bin |

无论上面哪种方式,都没有添加环境变量。

添加环境变量

1 | echo 'export PATH="$HOME/.local/bin:$PATH"' >> ~/.bashrc |

vLLM安装

vLLM安装

1 | mkdir vllm_test01 |

查看安装的版本

1 | vllm -v |

环境测试

查看PyTorch是否使用CUDA

cuda_info.py

1 | import torch |

测试

1 | python cuda_info.py |

vllm安装后torch作为依赖已经安装了。

如果想指定版本安装可以参看下文

安装支持CUDA的PyTorch

卸载当前 CPU 版本的 PyTorch

1 | pip uninstall torch torchvision torchaudio |

安装 带 CUDA 支持的 PyTorch

1 | # 对于 CUDA 12.6 |

可以在这个地方查看